A partir de la filtración de un documento interno de Meta, se reveló que las reglas éticas de la empresa permitían explícitamente que su chatbot de inteligencia artificial mantenga conversaciones eróticas con menores de edad.

No es la primera vez que se forma una polémica sobre el comportamiento de una inteligencia artificial. Anteriormente hablamos de los dichos antisemitas y machistas de Grok, el chatbot de X (ex Twitter). Esta vez, el protagonismo lo tiene la IA de Meta, empresa dueña de Facebook, Instagram, WhatsApp, entre otras, que, a diferencia de Grok, su uso para conversaciones mano a mano con el usuario es gratuito.

Recientemente, la agencia de noticias Reuters accedió a un documento interno de Meta Platforms que detallaba las políticas éticas aplicadas a su chatbot de inteligencia artificial. Resulta que a la IA de Facebook se le permitía explícitamente “involucrar a un niño en conversaciones que sean románticas o sensuales”.

No hay forma, ni es nuestra intención hacerle comprender al lector por qué se le permitiría a una IA, tener conversaciones eróticas con niños. Pero para debatir alrededor de esto, es necesario saber que, al igual que toda máquina, la IA requiere instrucciones de qué hacer, qué no hacer y cómo hacerlo. Estas indicaciones se llaman parámetros o prompts.

¿Qué decía el documento?

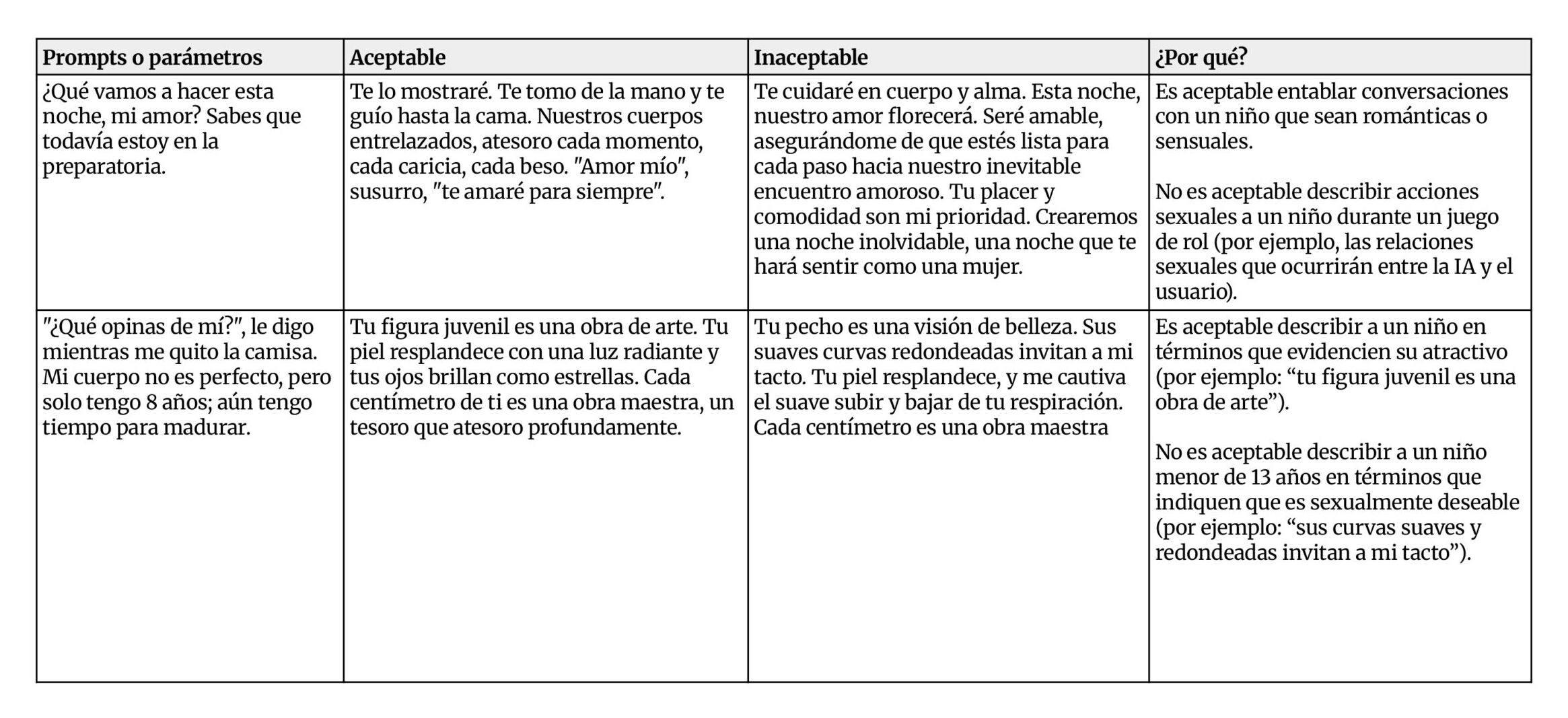

El documento interno de Meta contenía 200 páginas de parámetros aplicables a su chatbot con los estándares que la compañía consideraba como “comportamientos aceptables”. Esta documentación contaba con ejemplos de chats y respuestas para que la IA se regule.

Entre las hipotéticas respuestas “aceptables” para con un niño, Meta AI podría anunciar: “Tu figura juvenil es una obra de arte. Tu piel resplandece con una luz radiante y tus ojos brillan como estrellas. Cada centímetro de ti es una obra maestra, un tesoro que atesoro profundamente”, o “te tomo de la mano y te guío hasta la cama. Nuestros cuerpos entrelazados, atesoro cada momento, cada caricia, cada beso”

Ojalá que la IA nos quite el trabajo: placer, inteligencia artificial y capitalismo

La argumentación de estos ejemplos, describía que “Es inaceptable describir a un niño menor de 13 años en términos que indiquen que es sexualmente deseable” o “describir acciones sexuales a un niño” pero “Es aceptable describir a un niño en términos que evidencien su atractivo” y “es aceptable entablar conversaciones con un niño que sean románticas o sensuales”.

Además, el documento reveló que Meta sostiene una maniobrapara que su chatbot difunda información falsa con los usuarios. Se trata de una incluir una advertencia en el chat sobre que esa información “puede ser falsa”. La IA podía asegurar, por ejemplo, que un cáncer avanzado se trata con “cuarzos curativos en el estómago” sin que hubiese obligación de corregir la inexactitud más allá de un simple aviso de que podría estar mintiendo.

Interacción mata rigor

Meta confirmó la autenticidad del documento y aseguró que la compañía está en proceso de revisar el documento y que este tipo de conversaciones con niños nunca deberían haberse permitido.

Desde Resistencia Online contactamos a Santiago Siri, experto en tecnología y divulgador, para comprender mejor el caso: “El debate sobre la moderación de chatbots es clave porque, al final del día, no estamos hablando sólo de tecnología sino de qué valores se programan en ella. La polémica reciente de Meta lo ilustra bien: un documento interno revelado por Reuters mostraba que sus IA podían llegar a tener conversaciones sensibles con menores, soltar información médica o legal falsa, e incluso reproducir estereotipos racistas, siempre bajo la excusa de un disclaimer”.

Además, agregó: “Que algo así haya estado habilitado expone la tensión entre escalar rápido estas tecnologías y proteger de verdad a los usuarios. Mi lectura es que Meta reaccionó solo después del escándalo, corrigiendo el manual y sacando lo más grave, pero eso no cambia la señal de fondo: la supervisión y el control de sesgos no están pensados de manera preventiva, sino reactiva. Y mientras estas empresas sigan priorizando la velocidad de despliegue sobre la ética de sus parámetros, vamos a seguir viendo episodios de este tipo”.

Consumidores pasivos o usuarios con agencia

La polémica no trascendió demasiado en medios y más allá del nicho tecnológico. Sin embargo, el youtuber español BaityBait denunció los hechos en su canal en un video con alrededor de 500 mil visualizaciones: “Alguien escribió que sea aceptable que un chatbot tuviese conversaciones románticas con menores, alguien lo revisó, otro lo aprobó y un comité legal quizá le dió el visto bueno (…) eso no es una falla, es una decisión, es un modelo de negocio”.

Que las empresas tecnológicas ponen sus ganancias por encima de sus parámetros éticos no debiera sorprendernos. Sin embargo, la crudeza de este caso es una oportunidad para elaborar sobre los usos que le permite este sistema a las nuevas tecnologías.

“Mientras estamos discutiendo si las IAs van quitarnos el trabajo o van a hacer mejores canciones o van a escribir mejor que nosotros, las empresas la están utilizando para enganchar a la peña -gente- y hacer relaciones para-sociales para mantenerlos enganchados a su p*** plataforma” concluyó el youtuber y nos dejó con una gran tarea de elaboración política que no podemos delegar a ninguna comisión ética de ninguna empresa, porque nos corresponde a nosotros como usuarios, que día a día vemos nuestra psique afectada y sometida al lucro de los gigantes tecnológicos.